“De cajitas de fósforos al Chat-GPT”

¿ChatGPT es inteligente? ¿Crea o solo relaciona textos? A continuación, una reflexión sobre los alcances de esta herramienta.

Ing. Miguel Ángel Arrunátegui Angulo

Docente

Escuela Profesional de Ingeniería Informática

En mi reciente conferencia titulada “De las cajitas de fósforo al chat-GPT”, quise dar una idea de lo sorprendente de esta cosa que se llama inteligencia artificial.

Hace muchos años, en el libro de Martin Gardner “El ahorcamiento inesperado y otros entretenimientos matemáticos” encontré un capítulo muy interesante donde el autor narra un juego inventado por él, basado y en el ajedrez. En este se enfrentan tres peones blancos contra tres peones negros. El jugador humano se enfrentaba a una máquina implementada con cajitas de fósforo. Cada posición del juego era representada por una cajita, y los movimientos posibles por un conjunto de cuentas de colores.

Entonces, cuando se estaba en una determinada posición del juego, se agitaba la cajita correspondiente y se sacaba al azar una de estas cuentas de colores para realizar la jugada que el color indicaba en un mapa de jugadas posibles pegado en la cajita (figura 1) y se separaba la cajita con la cuenta extraída sin regresarla al interior. Esta era la jugada de “la máquina”.

Luego jugaba la persona y a su turno “la máquina” volvía a extraer una cuenta de la cajita que ahora correspondía a la posición a la que se había llegado en el juego y se realizaba el movimiento que el color de la cuenta extraída indicaba. Y así sucesivamente, hasta que el juego termina con la victoria del hombre o de “la máquina”.

En el caso de que la máquina hubiera perdido se le “castigaba”, quitándole las bolitas que le habían hecho jugar mal, para que estas jugadas no se repitan. Eventualmente, se podía premiar a la máquina, agregando una bolita del mismo color. Y así, después de varios juegos, “la máquina” aprendía de sus aciertos y errores. Las malas jugadas iban desapareciendo y las buenas aumentaban su probabilidad.

Años después, me enteré de que la máquina de cajitas de fósforos fue concebida años antes por Donald Michie, y lo que él hizo fue jugar al michi (tic-tac-toe), utilizando el mismo principio explicado, pero requería 304 cajitas, lo cual es más complicado de implementar. El entrenamiento de las cajitas para el juego se basa en el principio de Reforzamiento operante de Skinner (premio-castigo).

La IA

La inteligencia artificial, que está con nosotros desde hace medio siglo, se ha puesto nuevamente de moda desde fines de 2022, gracias a la compañía OpenAi y su producto Chat-GPT. Estamos viendo los resultados de unas máquinas que no tienen cajitas de fósforos, sino que están formadas por batallones de procesadores y memoria en las cuales se entrenan redes neuronales en una modalidad llamada Deep Learning (aprendizaje profundo).

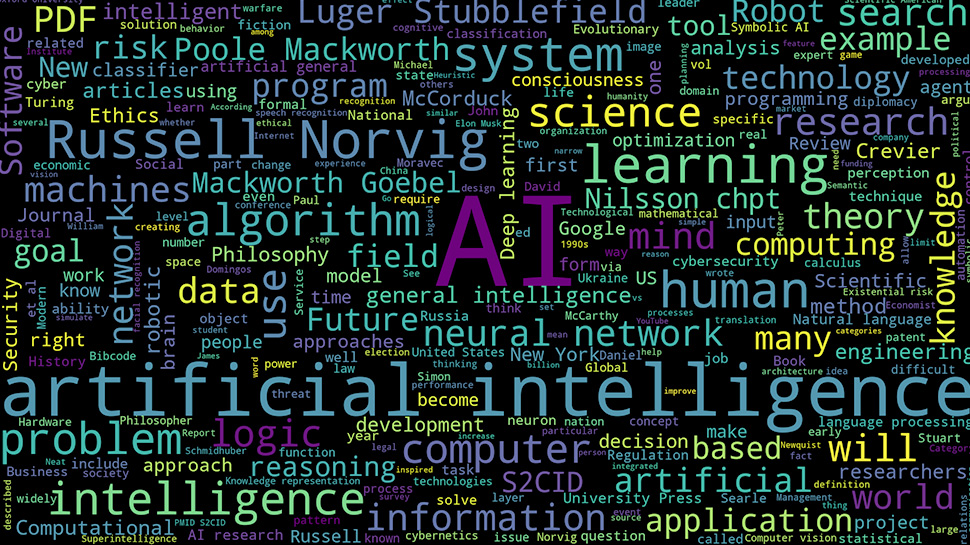

A las redes neuronales se les ha entrenado con información de dos fuentes principales muy importantes: la información de Wikipedia y la información de Common Crawl. Esto quiere decir que es como si nuestra máquina hubiera leído todos los artículos de Wikipedia y las páginas web de Common Crawl con las publicaciones en Internet: páginas web, artículos, blogs, chats, Feeds, RSS, entre otros, y de alguna forma “recordara” lo leído.

Las redes neuronales recurrentes del Chat-GPT, entrenadas en el contenido mencionado, son capaces de generar respuestas, contenido y diálogos, apelando a esta información, y combinarla, de forma que parece una respuesta humana.

¿Chat-GPT es inteligente?

La asombrosa inteligencia del Chat-GPT no lo es tanto, pues simplemente es un analizador y relacionador de los textos con los que se le entrenó (natural language processor). El chat-GPT no tiene inteligencia ni sensaciones, solamente relaciona textos. El chat-GPT identifica cada una de las palabras de un texto, por ejemplo “perro”, pero en realidad no tiene idea de lo que es, solo sabe que la letra p, seguida de las otras, es un conjunto de caracteres que aparece muchísimas veces en todos los textos.

Cosa similar sucede con la secuencia de letras “amo”, “dueño” y “amigo”, que también suelen andar juntas, formando frases en los textos. Además, sabe que donde dice “perro” por allí cerca se suele decir “amo” o “dueño” o “amigo”.

Tampoco sabe lo que significa “amo”, “dueño” o “amigo”. Solamente sabe que suelen ir junto a “perro”. A su vez, la palabra “dueño” también aparece junto a “casa” y a “automóvil”. Con su inmensa capacidad computacional, el chat-GPT codifica cada palabra, asignándole un código (un número), y lleva la cuenta de con qué otras palabras (otros números) se relaciona. Este esquema lo repite a nivel de frases como “el perro quiere a su amo”, a la que también se le asigna un código y se lleva cuenta de sus relaciones.

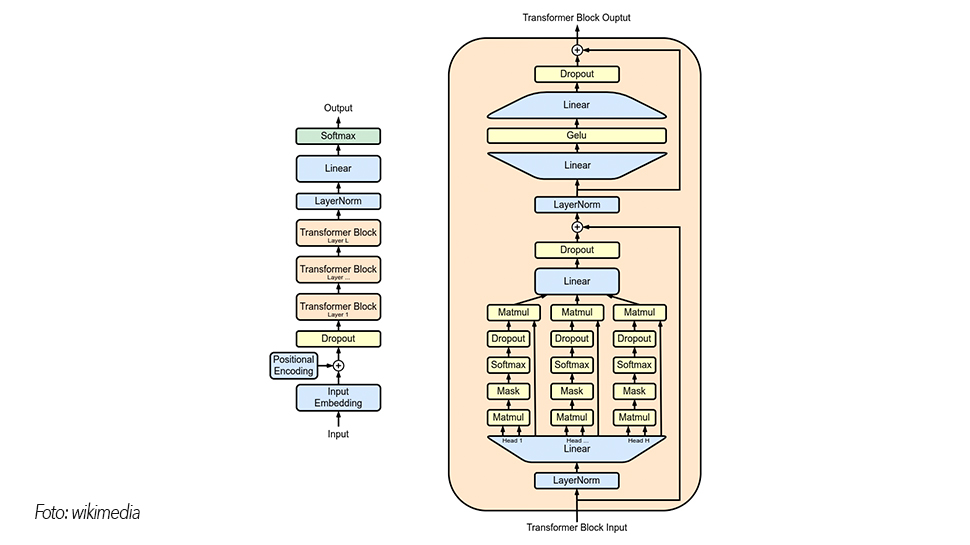

Al final, las palabras y frases poseen una nube de relaciones, una constelación n-dimensional de relaciones (figura 2) que se construyeron a partir del entrenamiento de la red neuronal. En el mundo del Deep Learning existen modelos de entrenamiento que sirven para distintos propósitos. En el caso del Chat-GPT, se ha utilizado un modelo llamado Transformer (figura 3). Los modelos Transformer aplican un conjunto en evolución de técnicas matemáticas llamadas atención o atención propia, para detectar formas sutiles en que los elementos de datos en una serie se influencian y dependen entre sí.

En el entrenamiento de la red neuronal se usan una serie de ajustes conforme se procesa la información, similarmente a un ecualizador de música o una consola de sonido, donde se dispone de unos controles deslizantes y perillas para ajustar el sonido. En el Chat-GPT se tiene también esa especie de controles de ajuste, se llaman parámetros y su número es de 175 billones (175 000 000 000).

Lo cierto es que la forma de trabajar de Chat-GPT no es sobre la base de conocer y saber qué son las cosas, sino simplemente de cómo es que aparecen relacionadas en la vida real, en base a los textos que se han escrito sobre estas palabras.

El modelo Transformer se basa en poder identificar qué es lo más importante en una frase. Cuando conversamos -porque es un chat– con el Chat-GPT y le pedimos algo, lo primero que va a hacer es determinar de qué estamos hablando, es decir va a determinar la atención, algo que hacemos cuando resaltamos un texto con el plumón. Por ejemplo, si le preguntamos por los implementos necesarios para escalar una montaña congelada, tratará de identificar en esa frase qué es lo importante. A esto se le llama la atención, entonces buscará en la constelación de palabras relacionadas y generará respuestas, combinando estas relaciones de manera coherente.

Si la atención es montañas y escalar, pues se centrará en las cosas montañas y sabrá que las palabras montaña y escalar se relacionan mucho con determinado deporte que se llama el alpinismo o el andinismo, y comenzará a buscar las relaciones dentro de esa información. Eventualmente, caerá en la parte de instrumentos, herramientas, vestido, etc., y generará las respuestas.

Generar frases lo hace bastante bien y responde educadamente. Si continuamos conversando, el Chat-GPT desplazará aleatoriamente el punto de atención hacia una posición cercana para generar más respuestas, y podría referirnos sobre accidentes, sitios y escaladores famosos.

El Chat-GPT 3.5 ha sido alimentado con información hasta el año 2021, esto quiere decir que no conoce información posterior, por lo que tampoco se le puede usar en reemplazo de Google, si de información reciente se trata.

No discierne

El Chat-GPT no tiene conciencia, no discierne, se basa en lo que han escrito y discernido otros y en las combinaciones que pueda hacer. Eso quiere decir que, si existe alguna información errada sobre la cual se ha escrito mucho, el Chat-GPT puede tomarla y presentárnosla como verdadera. Por esto se recomienda verificar con otras fuentes.

Existen muchos reportes de que puede inventar cosas y referir hechos que no han existido o relaciones que no se han dado o historias que no son del todo ciertas, porque simplemente las palabras aparecieron juntas por ahí y, si alguien ha puesto información falsa en internet, el Chat-GPT no sabe que es falsa: simplemente fue entrenado con esa información.

A tiempo de escribir este artículo, la ola de entusiasmo del Chat-GPT está bajando y, si bien es una de las ramas de la inteligencia artificial que ahorra tiempo en las búsquedas y puede generar texto y código, hay que tener cuidado, porque podríamos tomar como cierto algo falso. A esto se le llama “Alucinación IA”.

La inteligencia artificial todavía se estudia y analiza, aún falta mucho camino, camino positivo, beneficioso, esperanzador para la humanidad. La humanidad será potenciada con estos avances, pronto las nuevas generaciones la utilizarán de manera natural y transparente para ser mejores. Mientras tanto, animado por este artículo, me voy a ir un momento a preguntarle al chat-GPT por la fórmula de la Coca Cola y la receta del coronel Sanders.

Empresa Editora El Comercio

Copyright© elcomercio.pe – Grupo El Comercio

Todos los derechos reservados